Para este entregável, será demonstrado o projeto e testes dos softwares que compõe o projeto Talker V-EYE, no qual o projeto possui três softwares. Sendo estes o aplicativo que o usuário informa configurações para calibração, o software o qual irá detectar o objeto mais próximo com o retorno da câmera RGBD e o sensor óptico e o software que irá identificar o nome do objeto mais próximo e retornar por áudio.

Sendo assim, primeiramente será demonstrado os diagramas de caso de uso para cada software.

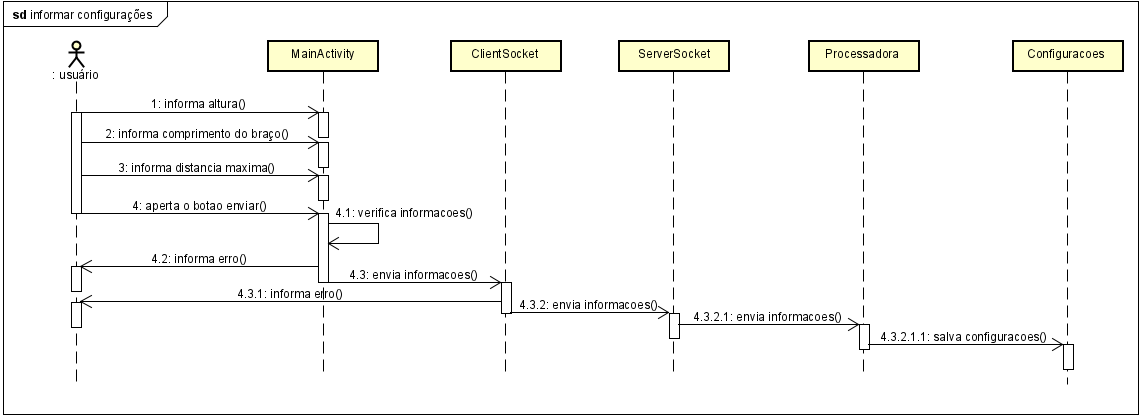

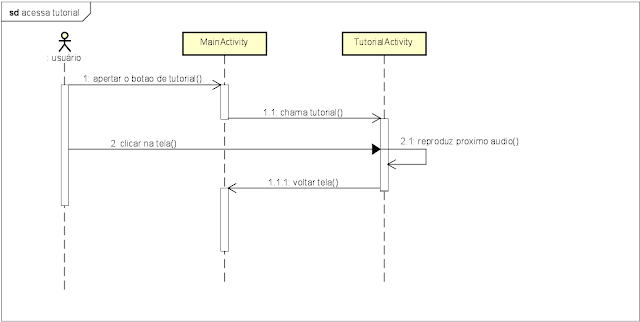

Por seguinte, os diagramas de sequência foram elaborados de acordo com cada caso de uso proposto.

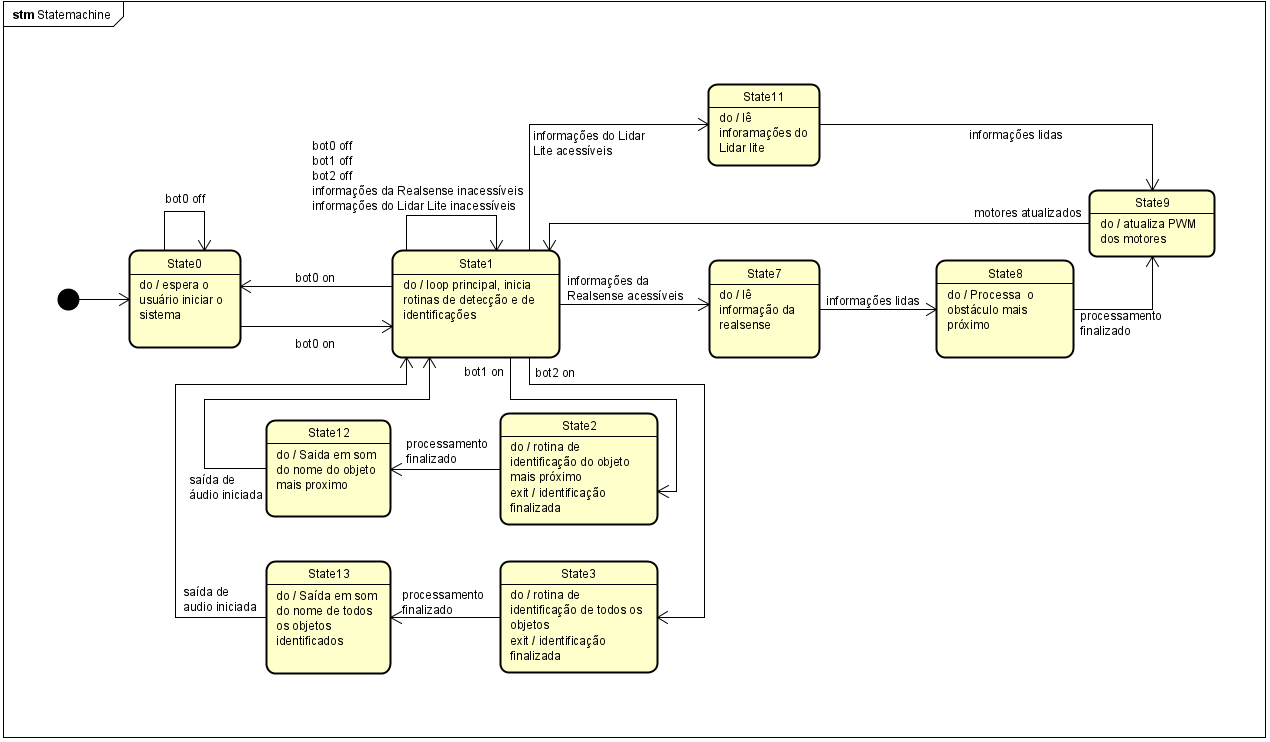

Além disso, foram elaborados o diagrama de estados do projeto, tendo a imagem do mesmo abaixo:

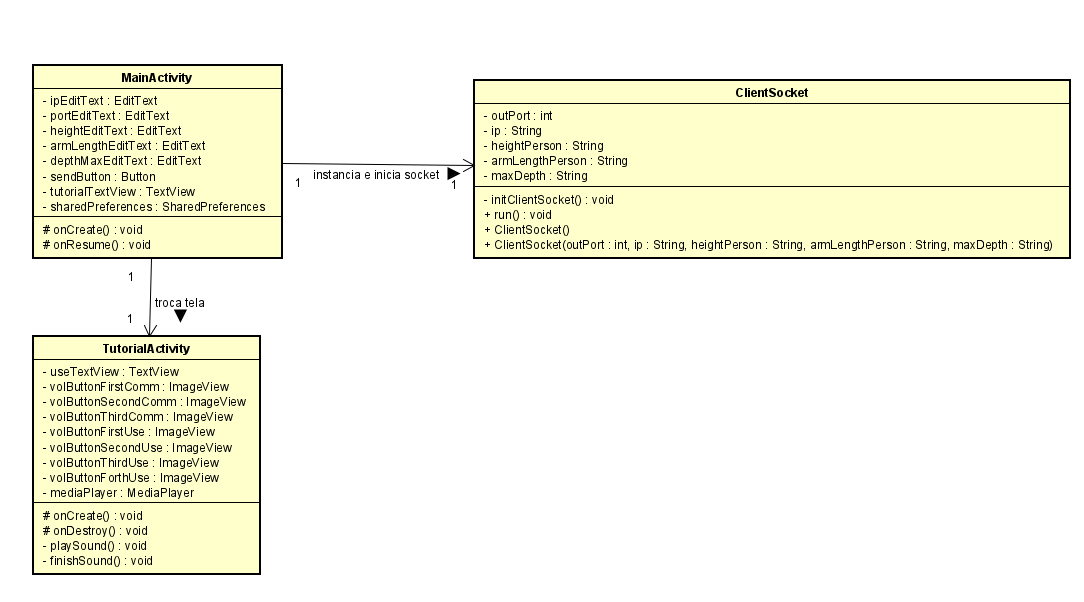

Por fim, os diagramas de Classe para cada software elaborado para o projeto.

Os testes dos softwares elaborados foram bem separados, possuindo ainda pouca ou nenhuma interação com outros sensores ou softwares, os quais serão finalizados durante o período de integração. Contudo, algumas partes já foram elaboradas, sendo a comunicação entre os softwares, que será através de conexão TCP/IP, utilizando Sockets.

Primeiramente, será demonstrado o teste com o que foi obtido na implementação da identificação de objetos, o qual foi utilizado a API Vision (para retornar o texto de objetos contidos na imagem) e a Text to Speech (converter texto em áudio). Abaixo, está os passos demonstrando o resultado obtido até o momento.

A imagem utilizada para testes, foi a seguinte imagem, a qual contém alguns objetos na mesma:

Primeiramente, essa imagem é enviada para a API Vision, o qual além de identificar os objetos na imagem (por nome), retorna outras informações importantes, como a posição do objeto na imagem, como é possível verificar na imagem a seguir:

Logo, com o nome dos objetos retornados, foi enviado os mesmos para API Text to Speech, o qual retornou um arquivo .mp3, demonstrando a execução a seguir.

A seguir, esta os testes feitos com os motores de vibração :

Adiante, está demonstrado o teste do softwares que comunica tanto com a câmera RGBD (Realsense) quanto o sensor óptico (Lidar):

Comentários

Postar um comentário